Pour EVALIR, chaque « danger » de l’IA devient une opportunité de design pédagogique, politique ou organisationnel.

Pour EVALIR, chaque « danger » de l’IA devient une opportunité de design pédagogique, politique ou organisationnel.

1. La paresse à penser → Fabriquer du muscle critique

Le danger.

Quand l’IA répond vite et “assez bien”, beaucoup s’arrêtent là. Le cerveau fait grève.

Renversement.

Puisque l’IA produit du “presque juste”, mais avec des failles visibles, on peut transformer ces failles en entraînements cognitifs.

Applications :

-

Jeunes : exercices où l’IA “hallucine volontairement”. L’élève doit détecter l’erreur, l’expliquer, la corriger. Petite mécanique de Sherlock Holmes numérique.

-

Cadres d’entreprise : protocoles d’analyse rapide : “tu génères 3 hypothèses IA, tu dois invalider au moins une”, pour éviter le conformisme algorithmique.

-

Décideurs et politiques : ateliers de décryptage où l’IA génère plusieurs scénarios contradictoires ; ils doivent repérer les biais implicites, les angles morts, les choix de valeurs cachés.

-

Agents territoriaux : exercices de vérification croisée (IA + source locale + document officiel), afin de leur donner un réflexe méthodique de validation.

2. Le risque de désinformation → Générer de la culture de vérification

Le danger.

L’IA peut amplifier des fausses infos à la vitesse de la lumière… et parfois en costard-cravate de vérité.

Renversement.

Utiliser l’IA pour produire volontairement des fake news plausibles afin d’entraîner les publics à les repérer.

Applications :

-

Jeunes : mini-jeux “vrai / presque vrai / complètement inventé”.

-

Cadres : audits de réputation simulés : “voici une rumeur générée, comment on installe un protocole de réponse ?”

-

Élus : simulations de circulation d’information en situation de crise locale (“inondation – rumeur – fausse photo – réaction ?”).

-

Administration : exercices d’évaluation systémique : impact d’un faux mail interne, d’une note altérée, d’un récit erroné.

3. Le risque de perte de compétences → Développer la compétence méta

Le danger.

Si l’IA rédige, structure, analyse… on peut perdre ses propres capacités cognitives.

Renversement.

On s’en sert comme d’un miroir : l’IA montre comment elle raisonne, et on apprend à raisonner sur son raisonnement.

Applications :

-

Jeunes : “explain your prompt” : l’élève doit expliquer la logique qu’il attend de l’IA avant même de demander la réponse.

-

Cadres : usage systématique du “double check IA/IA” : l’une propose, l’autre critique. Le manager arbitre.

-

Élus : travail sur la formulation d’objectifs : si l’IA interprète mal, c’est le signe que l’intention politique n’était pas claire.

-

Agents territoriaux : ateliers “littératie algorithmique” : comprendre ce qui influence vraiment la réponse du modèle.

4. Les biais algorithmiques → Une opportunité pour apprendre les biais humains

Le danger.

Les modèles reproduisent ou amplifient les biais de société.

Renversement.

L’IA permet de créer des situations pédagogiques impossibles en conditions réelles : “montre-moi les biais dans ce texte”, “génère-moi une version biaisée”, “donne-moi trois angles neutres”.

Applications :

-

Jeunes : exercices sur stéréotypes (CV, descriptions, images).

-

Cadres : audit IA des procédures internes : où les biais humains se nichent-ils ?

-

Élus : analyse de textes réglementaires sous différents angles (équité, inclusion, impact territorial).

-

Agents : scénarios d’accueil usagers “avec biais / sans biais” pour travailler l’éthique du service public.

5. Le risque d’industrialisation des décisions → Une pédagogie du discernement

Le danger.

L’IA pousse au “one-size-fits-all”, au modèle standardisé.

Renversement.

On utilise l’IA pour montrer par contraste ce qui manque : le contexte, l’intuition, le non-dit, le lien humain.

Applications :

-

Jeunes : exercices où l’IA donne la bonne réponse “technique”, mais l’élève doit formuler la réponse “humaine”.

-

Cadres : études de cas où l’IA propose trois décisions neutres, puis l’équipe ajoute la dimension organisationnelle, politique ou sociale.

-

Élus : simulations d’arbitrage : l’IA donne “la solution efficace”, eux doivent argumenter “la solution juste”.

-

Agents territoriaux : formation à la médiation augmentée : l’IA donne les points clés, l’agent construit la relation.

6. Le risque d’addiction / saturation numérique → Éducation à l’hygiène cognitive

Le danger.

L’IA partout = cerveau en burn-out, attention fragmentée.

Renversement.

On utilise l’IA pour mesurer l’attention, proposer des rituels de pause, aider au recentrage.

Applications :

-

Jeunes : IA comme coach de concentration (“analyse ton texte, repère quand tu te disperses”).

-

Cadres : protocoles “deep work augmenté” : l’IA isole les tâches, planifie les blocs sans surcharge.

-

Élus : aide à la priorisation : transformer 20 sujets en 3 décisions essentielles.

-

Administration : IA qui simplifie les flux internes, filtre le bruit informationnel.

7. Le risque de dépendance technologique → Une culture de souveraineté cognitive

Le danger.

Si on dépend trop de l’IA, on perd la maîtrise du raisonnement et des choix.

Renversement.

On crée des “moments de souveraineté” : exercices où l’IA n’a pas le dernier mot.

Applications :

-

Jeunes : “prompt interdit” : un exercice doit être fait uniquement par réflexion.

-

Cadres : IA comme second avis, jamais comme conclusion.

-

Élus : protocoles de transparence : l’IA propose, l’élu motive sa décision.

-

Agents territoriaux : rituels de double validation humaine : l’IA pré-trie, l’humain tranche.

8. Le risque d’IA opaque → Une pédagogie de la transparence

Le danger.

Personne ne comprend “ce qu’il y a dedans”.

Renversement.

En s’appuyant sur les erreurs, biais, versions contradictoires… on montre comment l’IA fonctionne.

Applications :

-

Jeunes : jeux “dans la tête du modèle”.

-

Cadres : mapping de la chaîne de traitement (données, filtres, modèle, vérification).

-

Élus : analyse des impacts politiques de l’opacité.

-

Agents : formation à la documentation des usages IA.

9. Le risque d’automatiser le lien social → Renforcer la présence humaine

Le danger.

Des chatbots remplacent le contact humain, au détriment du lien.

Renversement.

On utilise l’IA pour préparer, améliorer, décharger… mais pas pour remplacer l’interaction.

Applications :

-

Jeunes : IA comme partenaire d’entraînement, pas comme confident.

-

Cadres : IA pour préparer les réunions, libérant du temps pour le relationnel.

-

Élus : IA pour éclairer les enjeux d’un projet, mais les consultations restent humaines.

-

Agents : IA pour orienter, humain pour accompagner.

A PROPOS DE EVALIR

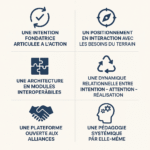

Plateforme d’acculturation – Conférences – Ateliers :

Les prestations d’Evalir à la manière d’un cadran stratégique

| Approche immédiate (pragmatique, outils, usage terrain) | Approche stratégique (sens, vision, long terme) | |

|---|---|---|

| Acculturation & pédagogie | ✨ Comprendre les bases de l’IA, repérer les biais, démystifier les usages 🧩 Ateliers interactifs, exercices scénarisés, serious games |

🌍 Réfléchir au rôle de l’IA dans son métier, son secteur, sa commune 📚 Conférences d’élévation (Moments de décodage et d’orientation), accompagnement stratégie et décision |

| Réponse aux besoins concrets | 🛠️ Quels outils peuvent m’aider ? Comment gagner du temps ? 🗂️ Ateliers-action, ateliers métiers (commerçants, agents, enseignants) |

🧠 Comment articuler IA, transition numérique et cap politique ? 🗺️ Conférences prospectives, séminaires dirigeants |