🤔 Pourquoi discuter avec un LLM ?

L’événement organisé par la Chaire de métaphysique et philosophie de la connaissance (prof. Claudine Tiercelin) s’est attaché à explorer un thème brûlant : les implications philosophiques, épistémologiques et éthiques des IA génératives comme les LLM (Large Language Models).

Le professeur Daniel Handler, spécialiste de philosophie des sciences cognitives, a proposé une analyse fascinante des conversations avec des IA comme ChatGPT. Il montre qu’au-delà du jeu ou de la recherche d’informations rapides, interagir avec un LLM révèle un phénomène surprenant : ces systèmes peuvent simuler des discussions riches et cohérentes, au point que des philosophes expérimentés se prennent à considérer le dialogue comme presque « sérieux ».

📚 Exemples marquants : comprendre le paradoxe

-

Un ami du conférencier a interrogé ChatGPT sur la philosophie et reçu des réponses étonnamment réflexives, la machine analysant la manière dont on la questionne et comment ses propres réponses se construisent.

-

Le cas troublant de Christian Floy, philosophe autrichienne : ChatGPT l’a déclarée morte… alors qu’elle-même le corrigeait en direct ! Cela illustre la limite fondamentale : un LLM peut générer des affirmations fausses avec aplomb, et même s’excuser de façon polie mais mécanique, sans conscience.

🎯 La question centrale : le LLM « comprend-il » vraiment ?

La position dominante dans le milieu scientifique considère que les LLM n’ont pas de compréhension véritable, mais produisent des suites de mots plausibles grâce à des probabilités calculées à partir d’énormes corpus de textes. C’est ce qu’illustre la métaphore du « perroquet stochastique » : le LLM répète des formes linguistiques sans contact avec la réalité.

Mais Daniel Handler défend une nuance : même si un LLM n’a pas d’expérience du monde, la structure même du langage qu’il manipule contient des traces d’un modèle du monde. Il peut donc parfois sembler « comprendre », car le langage encode indirectement des représentations partagées.

📍 Limites et perspectives

-

Un LLM ne dispose pas de « situation » : il n’est jamais engagé dans un contexte personnel, n’a pas d’enjeux, ne cherche pas activement à comprendre ni à convaincre.

-

Il peut simuler la compréhension, mais sans profondeur : il manque de « saut conceptuel », d’initiative, de créativité véritable.

-

Pourtant, le LLM peut être un sparring partner utile pour clarifier sa pensée, tester des hypothèses ou apprendre à argumenter.

🚦 Conclusion : que retenir ?

Les discussions avec un LLM posent un défi intellectuel et pratique : elles nous confrontent à la frontière floue entre langage et compréhension, tout en bouleversant notre rapport à la connaissance. Même si ces systèmes restent des automates puissants, leur capacité à structurer des réponses soulève des enjeux éthiques, épistémologiques et même politiques majeurs.

🔎 Le sens humain vs le « sens » du LLM

-

La position dominante aujourd’hui est que les LLM ne « comprennent » pas le sens comme un humain : ils produisent des enchaînements de mots plausibles, mais sans lien avec la réalité. Leur « compréhension » est purement statistique et syntaxique.

-

Cette idée est illustrée par l’image célèbre du perroquet stochastique : un LLM ressemble à un perroquet qui répète des phrases, sans conscience ni compréhension du monde.

-

Pourtant, Handler nuance ce constat : le langage lui-même encode une forme de modèle du monde. En apprenant sur d’énormes bases de textes, le LLM intègre des régularités qui lui permettent de simuler une certaine cohérence et, parfois, de produire des réponses qui paraissent « sensées ».

📚 Le “symbol grounding problem”

-

Handler reprend le concept de symbol grounding problem : comment un système, qu’il soit humain ou machine, relie-t-il des symboles (mots) à une signification ancrée dans la réalité ?

-

Il évoque la version adaptée aux LLM, appelée vector grounding problem : comme les symboles sont des vecteurs mathématiques dans un LLM, la question devient de savoir comment ces vecteurs peuvent coder quelque chose qui ressemble à un modèle du monde — alors que la machine n’a pas d’expérience sensorielle.

🎯 Sa thèse centrale

-

Même si le LLM n’a pas de compréhension « consciente », il modélise partiellement le monde à travers le langage, car la complexité du langage humain enferme déjà une représentation du réel.

-

En d’autres termes, le LLM n’a pas de sens vécu ou expérientiel, mais il produit un sens structurel — une cohérence émergente, liée à la richesse statistique et sémantique de sa base d’entraînement.

💡 En clair : pour Handler, le sens dans un LLM n’est pas absent, mais il est radicalement différent de notre sens humain : un sens sans expérience, sans situation, sans engagement, mais qui peut quand même produire des réponses qui nous semblent « pleines de sens » grâce à la puissance du langage.

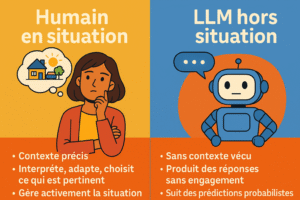

Sur la notion de situation

le professeur Daniel Handler insiste beaucoup, car pour lui, c’est une clé pour comprendre pourquoi un LLM ne pense pas comme nous. Voici l’essentiel :

🔎 Qu’est-ce qu’une situation ?

-

Pour un être humain, une situation, c’est un moment unique où l’on est physiquement, émotionnellement et intellectuellement engagé : un lieu, un instant précis, des attentes, des intentions, des enjeux personnels.

-

Dans une situation, on sélectionne certains éléments du contexte comme pertinents (ce que je vois, ce qui me préoccupe) et on agit ou parle en fonction de ces éléments. C’est vivant, dynamique, subjectif.

-

La situation est centrée sur l’agent : chacun vit une situation différemment, selon son expérience, ses souvenirs, son humeur. Et elle porte toujours un enjeu : on veut s’en sortir, résoudre un problème, ou simplement bien communiquer.

🤖 Pourquoi un LLM n’a-t-il pas de situation ?

-

Un LLM, même s’il dialogue de façon impressionnante, n’est pas engagé : il n’a pas de corps, pas de lieu, pas de moment, pas d’enjeu. Il ne « vit » pas ce qu’il produit.

-

Il répond à un prompt de manière détachée et impersonnelle, sans se situer dans un contexte réel.

-

Il ne comprend pas ce qu’est une situation humaine : par exemple, il peut dire à quelqu’un qu’il est mort, puis s’excuser poliment — mais sans ressentir ce que signifierait réellement une telle erreur pour la personne en face.

-

Il ne choisit pas les éléments pertinents de façon consciente : il calcule des probabilités sur des chaînes de mots, sans intention, sans objectif propre, sans compréhension de l’enjeu.

🎯 La grande différence selon Handler

-

L’intelligence humaine, dit-il, est avant tout l’art de gérer des situations : capter ce qui est important ici et maintenant, adapter sa réponse à l’autre, ajuster sa pensée à un contexte mouvant.

-

Un LLM, même s’il peut donner des réponses qui semblent pertinentes, n’est jamais en situation. Il simule une conversation, mais sans engagement, sans but, sans la dimension normative (la capacité à juger ce qui est approprié, juste, respectueux) qui caractérise notre intelligence dans une situation réelle.

💡 En résumé : pour Handler, c’est l’absence de situation qui marque la frontière la plus nette entre un LLM et un humain : le LLM produit des mots hors-sol, alors que nous, humains, pensons toujours depuis une situation vécue, qui oriente notre attention et donne du sens à nos actions.

A PROPOS DE EVALIR

Plateforme d’acculturation – Conférences – Ateliers :

Les prestations d’Evalir à la manière d’un cadran stratégique

| Approche immédiate (pragmatique, outils, usage terrain) | Approche stratégique (sens, vision, long terme) | |

|---|---|---|

| Acculturation & pédagogie | ✨ Comprendre les bases de l’IA, repérer les biais, démystifier les usages 🧩 Ateliers interactifs, exercices scénarisés, serious games |

🌍 Réfléchir au rôle de l’IA dans son métier, son secteur, sa commune 📚 Conférences d’élévation (Moments de décodage et d’orientation), accompagnement stratégie et décision |

| Réponse aux besoins concrets | 🛠️ Quels outils peuvent m’aider ? Comment gagner du temps ? 🗂️ Ateliers-action, ateliers métiers (commerçants, agents, enseignants) |

🧠 Comment articuler IA, transition numérique et cap politique ? 🗺️ Conférences prospectives, séminaires dirigeants |

Téléphone

07 70 38 84 34

Addresse

25 bis rue de Cahors, 24200 Sarlat, France